【Deep Learning】AlexNetの解説&実装 by PyTorch (colabリンク付き)

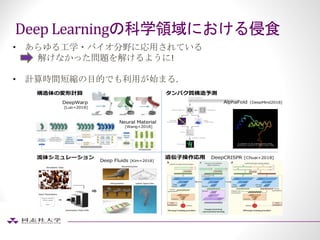

- 2. Deep Learningのもたらした衝撃 • 画像認識やNLP,音声認識の分野はもはやDeep Learning一色! • Deep Learningが用いられて成功している分野は以下のように様変わり • 従来: モデリング + 特徴量エンジニアリング + アルゴリズム開発 Ø モデリング = 数学や物理を用いた問題の定式化 Ø その問題を解くアルゴリズムの選択・開発 • 現在 : ネットワーク構造の設計 + 訓練データ構築 Ø NNが特徴量抽出を全て行ってくれる.

- 7. Semantic Segmantation U-Net, 2015 • 検出だけでなく, 物体ごとにMaskするsegmentation taskも高精度で可能に! • 医療系への応用が進む.

- 8. Instance Segmentation Mask R-CNN, 2017 • 物体ごとにsegmentationしてくれるDNNも開発されて, robotics系への応 用も進む.

- 9. Transfer Learning • ImageNetなどのpre-trainingされた重みを用いて, Fine-Tuningを 行うことにより, 少ないデータセットでも高精度のモデル作り が可能に! 自前データだけ Pre-train + fine-tuning

- 10. Deep Learningは教養 • 機械学習エンジニアとしてやっていくとしたら, 簡単な画像認識ぐ らいのDeep Learningの知識は教養みたいな世界になっている… • そこで, 今回は世界を一変させた伝説的論文の簡単な解説と実際に PyTrochによる実装を行います. • PythonとNumpy使った事のある人なら実装見たら大体わかる(はず).

- 11. 論文情報 • Title: ImageNet Classification with Deep Convolutional Neural Networks • 発行年: 2012 • 著者: Alex Krizhevsky, Ilya Sutskever, Geoffrey Hinton. • Deep Learningの火付け役となった, いわゆるAlexNetについての論文. • 本日は, この伝説的論文の簡単な解説とPyTorchによる実装を行う.

- 12. 目的 • 2012年当時の機械学習的なアプローチによる画像認識タスクは, 良い 性能を出すモデルを作るために, 自分たちで大きなデータセットを集 めることができた • CIFAR10/100などの数万オーダーぐらいのデータセットはかなり良い 成績をおさめていたが, 1500万, 2.2万カテゴリーがある大規模なデー タセット(ImageNet)を学習するためには, もっと大きなモデルを構築 する必要があった. • しかし, 今までのSOTA手法(当時はSVMなど)では取り扱うことができ ない…

- 13. 目的 • そこで, Le-CunやHintonなどに代表されるCNNに注目した. Ø CNNは層の数(depth)やユニット数(width)の数を変えることによ り, 大規模なモデルを構築できる. Ø CNNはFeed-forward NNと比べて, Connectionやパラメータ数を抑 えながら学習ができるので, 簡単に学習ができるから. • また, CNN長年の課題であった計算コストも, GPUを使うことで解決 できる可能性があったから.

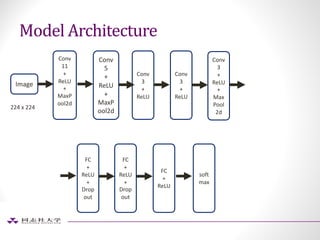

- 14. 目的(主張したいこと) • LSVRC-2012のtop5カテゴリーでエラー率15.3%を記録し, 2位(26.2%) 以下を大きく引き離し優勝したConvolution Neural Networkについて の解説. • モデルが”Deep”であることが重要であることを主張したい. • 活性化関数にReLUを用いるのが, 計算面でベストである. • 最近reguraization目的で開発したDropoutは結構効果的である. • 今後は, メモリサイズが大きいGPUを開発することがこの分野の発 展につながることを主張.

- 15. Dataset • 大会ルールに則り, ImageNetから1000カテゴリー からなるRGB画像130万 を取ってきて以下の様にデータを分割して学習する. Ø Training data: 1.2 million Ø Validation data: 50 thousand Ø Test data : 150 thousand • 224 x 224にdown-samplingして学習させた. • 指標: Ø モデルが予測するカテゴリーの中で正解データがTop1 or top5に入っ てれば正解とする.

- 16. ReLU関数の有効性 • 他に今まで使われてきた活性化関数より学習が進むのが早い! • 活性化関数にReLUとtanhを用いた時 にCIFAR-10を用いた実験. • 学習時のエラー率が25%になるまで エポックを回した時の比較 勾配消失が起こりにくいから

- 17. 勾配の値のプロット

- 20. Regulaization by Dropout • Hintonらによって発表されたNN専用の正則化手法. Ø 現在でも使われている. • 学習時にFC層に対して確率Pでノードを凍結させ, 学習させない 様にする. こうする事で, 過剰に学習することを防ごうというの がモチベーション. Srivastava, Hinton et al, Dropout: A Simple Way to Prevent Neural Networks from Overfitting, 2014

- 24. Disucussion & まとめ • 大規模でDeepなCNNが画像認識において極めて有効なことを示した. • 活性化関数に関しては, ReLUが一番良い. • Dropoutによる正則化は有効! • もっと大規模なCNNが実現できるマシンパワーを獲得できるなら, モ デルの精度はもっと伸びることが期待できる. • Nvidia社による高性能なGPUの開発のきっかけにつながった!